TEKNIKHISTORIA

Fem historiska steg från hjärnforskning till Chat GPT

Ai-modellen Chat GPT har bara existerat sedan 2022 – men artificiella neuronnät av den typen beskrevs redan på 1940-talet. Precis som den mänskliga hjärnan lär sig neuronnät av stora mängder data, kräver mycket beräkningskraft och älskar när de får en dos extra uppmärksamhet. Här är fem milstolpar som har lett fram till dagens språkmodeller.

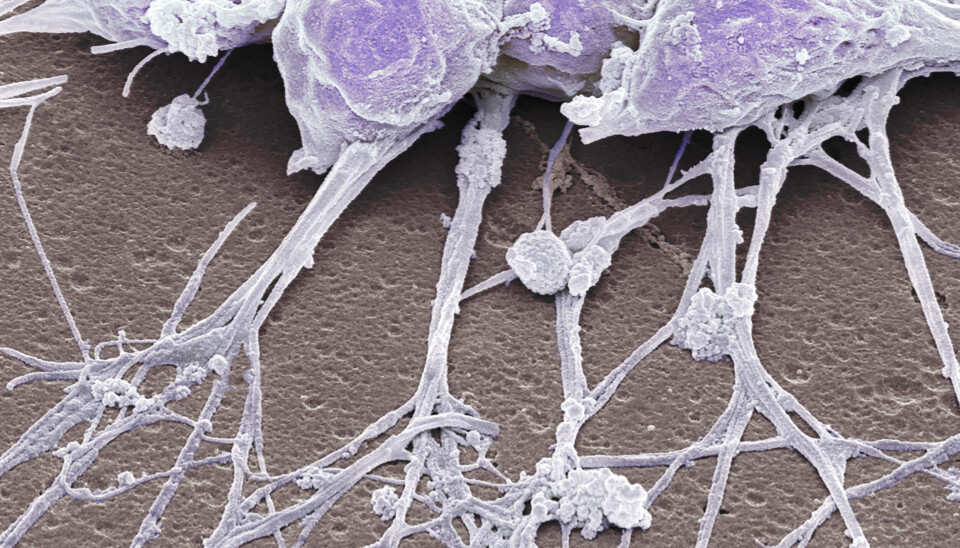

1873: Nya insikter om hjärnans signalering

Tack vare de kraftfulla mikroskop som uppfunnits hade vetenskapen vunnit nya insikter om hjärnan: Att den bestod av neuroner sammankopplade med andra neuroner i ett nätverk. En nervcell, såg man, kunde sända ut signaler till många andra nervceller. En nervcell kunde ta emot signaler från många andra nervceller.

Den skotska filosofen Alexander Bain föreslog att information skapades i själva konnektiviteten (hur kommunikationen sker mellan olika områden i hjärnan) mellan neuroner. Olika kombinationer av input kan ge olika output. Eller, uttryckt på ett annat sätt: olika beräkningar kunde äga rum.

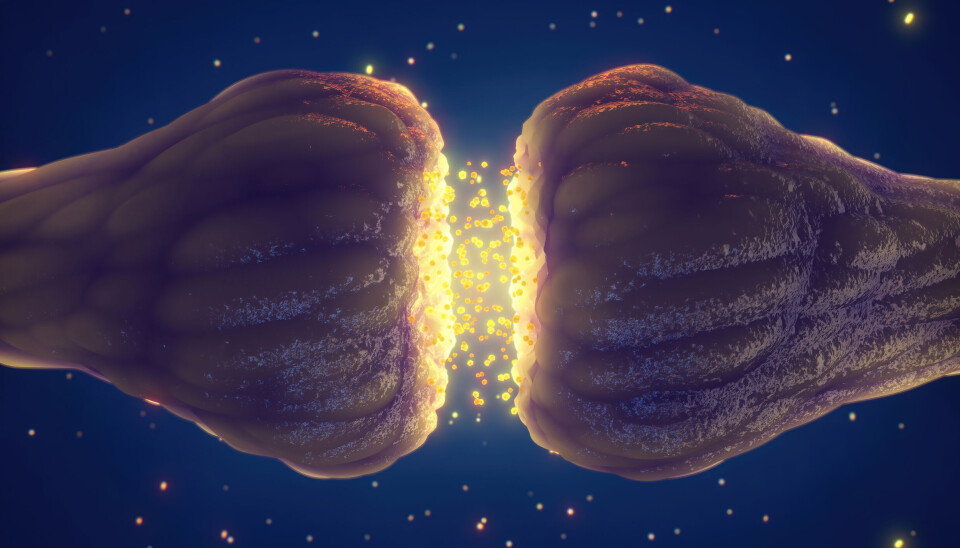

1949: Hebbs postulat om hur neuroner samverkar

Psykologen Donalds Hebb antog att om en neuron A upprepade gånger stimulerar en neuron B kommer sammankopplingen – eller vikten – mellan A och B att förstärkas. Vi lär oss, som Hebb uttryckte det, att ”cells that fire together, wire together”.

Så kallad

hebbiansk inlärning är ofullständig om man vill förstå hur människor anskaffar

och lagrar kunskap, men teorin har kommit att spela en roll för artificiella

neuronnät hela vägen fram till dagens stora ai-språkmodeller. Chat GPT består

av en modell där signaler matas in, viktas och genererar en utmatning.

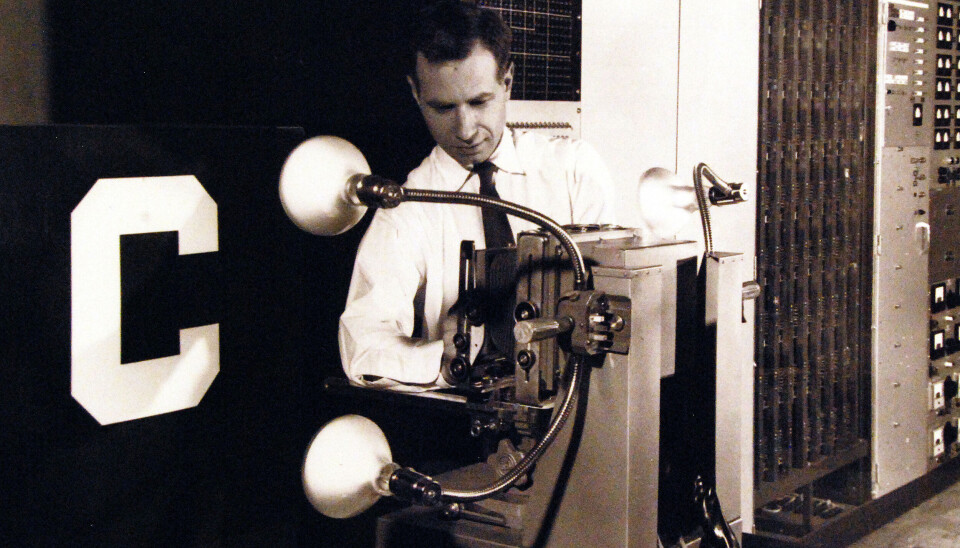

1958: Perceptronen – ”elektrisk hjärna lär sig på egen hand”

I en artikel i New York Times presenteras ai-modellen perceptron under rubriken ”Elektrisk hjärna lär sig på egen hand”. Perceptron, utvecklad av forskaren Frank Rosenblatt (bilden), var förverkligandet av det artificiella neuronnät som två andra forskare, Walter Pitts and Warren McCulloch, beskrivit redan 1943. De hade i sin tur inspirerats av Alexander Bain.

Frank Rosenblatts perceptron bestod av två lager (inmatning och utmatning), medan moderna neurala nätverk kan bestå av hundratals lager. Perceptronen var ett grunt neuralt nätverk, men vi är förstås mer bekanta med djupa neurala nätverk. Därav begreppet djupinlärning, eller deep learning.

Trots den andlösa rubriken i New York Times visade sig Rosenblatts skapelse vara ytterst begränsad.

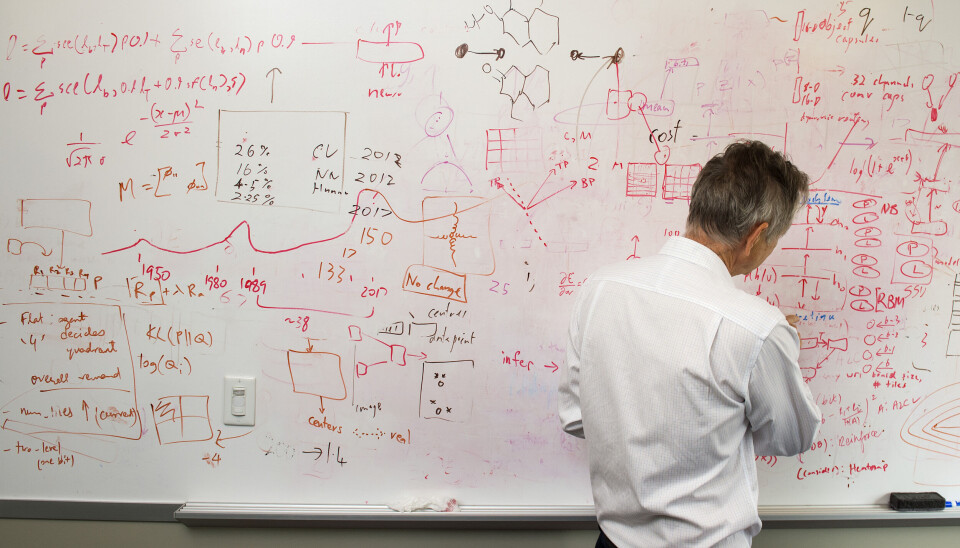

2012: Genombrottet som tog ai till nästa nivå

Det Walter Pitts, Warren McCulloch och Frank Rosenblatt lagt grunden för kallas konnektionistisk ai. I många årtionden var den helt åsidosatt till förmån för symbolisk ai, som kräver mer mänsklig handpåläggning.

Men numera har neuronnät, så kallad konnektionistisk ai, kommit att dominera så till den grad att symbolisk ai börjat kallas GOFAI (good old-fashioned ai).

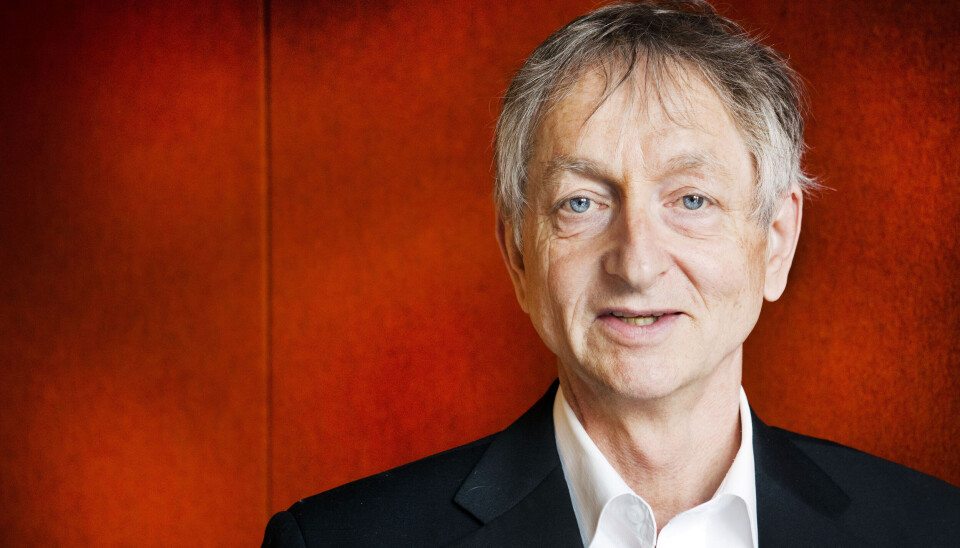

Genombrottet kom 2012 när datorpionjären Geoffrey Hinton (bilden) och två av hans elever, Alex Krizhevsky och Ilya Sutskever, skapade en på den tiden aldrig skådad ai-modell för att klassificera bilder. Trion hade tillgång till saker Frank Rosenblatt bara kunnat drömma om: stora datamängder, mycket beräkningskraft, förfinade algoritmer och djupa nätverk. Det var vad som krävdes för att ta ai till nästa nivå.

2017: Uppmärksamhet är allt Chat GPT behöver

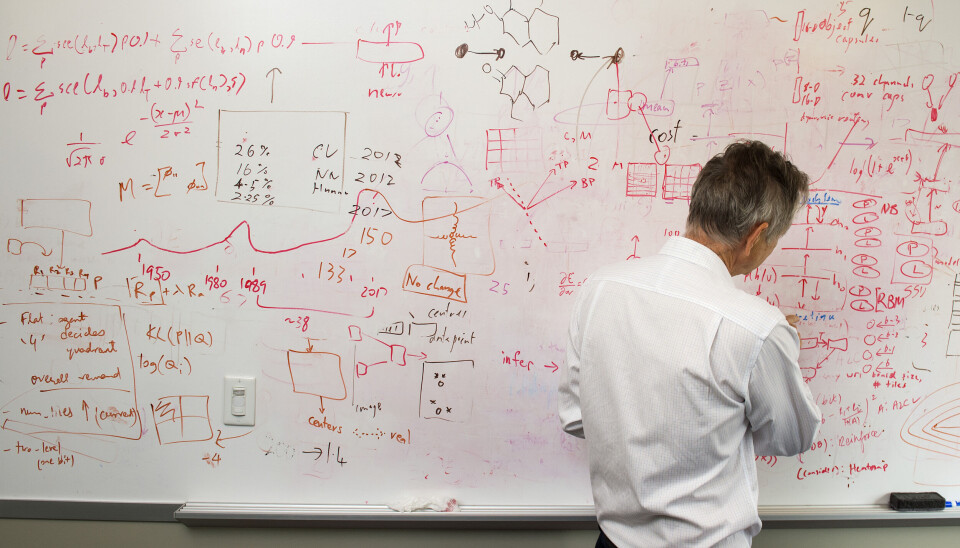

En ny ai-arkitektur – beskriven i en vetenskaplig artikel med den uppseendeväckande rubriken “Attention is all you need” - presenteras av forskare på Google. De kallar den transformer. Om djupa neuronnät tidigare byggt på lokala kopplingar mellan de artificiella neuronerna kan en transformer fästa sin uppmärksamhet på alla noder i nätverket på en och samma gång.

Uppmärksamhet var, som sagt, allt man behövde. Ja, uppmärksamhet och – återigen – de senaste grafiska processorerna. Fram till nyligen var det inte möjligt att implementera den extremt parallelliserade arkitektur som forskarna propagerade för. Parallellisering innebär att ett problem delas upp i mindre delar men sedan löses samtidigt.

Transformerarkitektur är det som ligger bakom framgångarna för stora språkmodeller som Chat GPT.