Premium

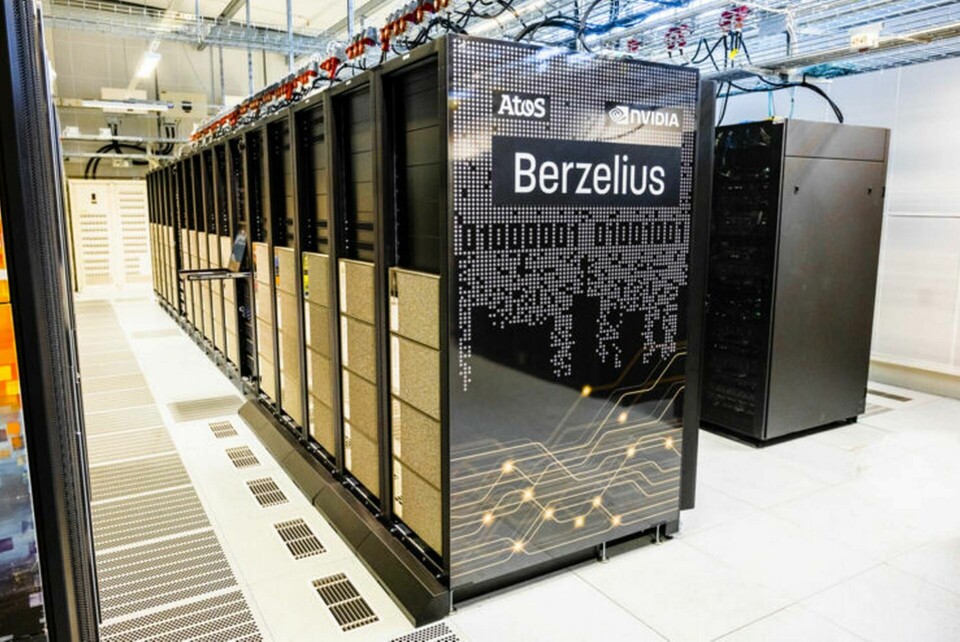

GPT-3 på svenska – de bygger en ”superintelligens” som pratar svenska

Språkmodellen GPT-3 slog världen med häpnad. Nu utvecklas en ny version, en enorm ai-modell – som talar svenska. ”Den kan lösa uppgifter den inte är tränad för”, säger Magnus Sahlgren på AI Sweden.

Annons